Иногда один документ скрывает в себе гораздо больше структуры, чем видно на первый взгляд. Со временем я заметил, что если разобрать его онтологически, он перестаёт быть текстом и превращается в сеть смыслов. Для меня это уже давно не эксперимент, а обычный рабочий процесс: беру документ, запускаю OntoLex — и провожу свой семантический ритуал. Презентация раскладывается на страницы, страницы — на термины, термины — на связи, и в итоге документ растворяется в графе, оставляя после себя живую модель знаний.

Зачем мне живые онтологии в повседневной работе

В любой даже очень опытной команде есть невидимый слой работы — мы обмениваемся смыслами, притворяясь, что обмениваемся словами. Для одного «проект» — это инициатива, для другого — бюджет, для третьего — просто папка в Jira. «Клиент» в одном контуре — человек, в другом — юрлицо, в третьем — сегмент, в четвёртом — запись в CRM или вообще API. Пока команда маленькая, это живёт как фоновый шум. Но как только начинаются рост, интеграции и сложные изменения, этот шум превращается в системные ошибки.

В цифровых моделях, особенно графовых, это ощущается болезненно. Каждый объект связан с десятками других, и от того, как именно мы назвали сущность и что под этим понимаем, напрямую зависит поведение AI-агентов и людей. Одно размазанное слово в одном месте даёт криво настроенный отчёт, неправильный вывод или лишнюю доработку где-то совсем в другом. В какой-то момент я поймал себя на простой, но неприятной мысли: главная слабость сложных систем — не столько архитектура и не только данные, а язык, на котором всё это описано.

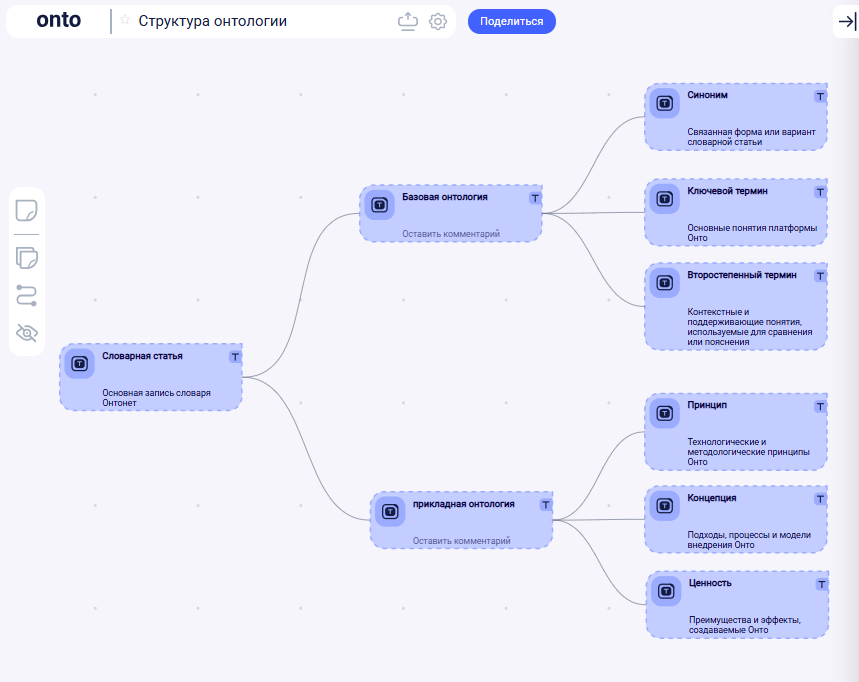

С этого момента у меня появилась рутинная практика: под любой серьёзный проект я поднимаю слой живой онтологии — словаря, встроенного прямо в модель. Не PDF с терминами на финальном слайде и не «где-то был глоссарий в Confluence», а отдельный смысловой слой, который живёт в том же графе, что и процессы, продукты, метрики, системы. Этот слой превращает хаос терминов в управляемую лексику, которую видят и люди, и AI. Модель начинает вести себя предсказуемо: меньше недопониманий, меньше дубликатов сущностей, меньше серых зон, где каждый «и так всё понимает».

Практический эффект очень прозаичен:

— постановка задач перестаёт превращаться в переписку «а что ты имел в виду под…»,

— моделирование процессов и продуктов ускоряется, потому что ключевые понятия уже разобраны,

— API проектируются на одном языке с бизнесом, а не на языке случайных полей,

— анализ изменений становится не гаданием, а разбором: видно, какие понятия задеты, а какие нет,

— навигация по графу превращается в осмысленное путешествие, а не в игру «найди нужный узел»,

— AI-агенты опираются на тот же словарь, что и команда, а не на собственные догадки.

По сути, такой словарь — это единый языковой интерфейс к системе. Строгий, но живой, контекстный, меняющийся вместе с моделью.

Если этот словарь поднят в Onto через OntoLex, он не просто хранит слова. Он знает связи между ними, контексты применения, источники определений, зависимости, синонимы и «родословные» понятий. Я ориентируюсь в предметной области быстрее, чем по любой документации: термины не лежат мёртвым списком, они вплетены в граф. Язык команды становится таким же объектом архитектуры, как сервисы и данные. И это уже не разовая «разработка глоссария», а регулярная практика, к которой хочется возвращаться на каждом новом документе.

Собственно, ради этого текста я зафиксировал один из таких типовых ритуалов — как из обычной презентации сделать живую онтологию, встроить её в существующую модель и получить словарь, который наконец-то работает, а не лежит отдельно.

Как отсутствие словаря ломает модели и команды

Если в обычной жизни разные трактовки слов заканчиваются максимум испорченной встречей, то в цифровых моделях цена ошибки совсем другая. Особенно в графовых, где каждый объект связан с десятками других. Любое размытое понятие в таком контексте становится не «мелкой неточностью», а конструктивным дефектом: оно расползается по узлам, порождает неверные зависимости и заражает смысл всей системы.

На практике это выглядит очень приземлённо.

Ты создаёшь сущность «Клиент» — и уверен, что всё очевидно.

Но одна команда под «клиентом» понимает физлицо, другая — компанию, третья — договор, четвёртая — запись в биллинге. В графе это превращается в парадокс: узел называется одинаково, а описывает четыре разные сущности. Где-то это ещё терпимо, но как только нужно принимать решения, считать метрики или строить новые сервисы — всё начинает конфликтовать.

С процессами ровно такая же история.

«Проект» — это проект разработки? Бизнес-инициатива? Проектная команда? Бюджет? План-факт?

Пока система живёт в голове одного архитектора и пары аналитиков — она держится.

Но как только начинаются изменения, интеграции, обмен моделями между командами, внедрение AI — скрытые расхождения вылезают на поверхность, и модели начинают буксовать.

Ситуацию усугубляет то, что AI-агенты честно усиливают то, что им дают. Они не могут «интуитивно почувствовать», что под одним и тем же словом разные люди подразумевают разное. Они просто берут контекст: если термин плавает между смыслами, агент будет действовать непредсказуемо. Никакие «идеальные пайплайны» не спасут, если язык не определён.

Поэтому отсутствие словаря — это не «у нас просто нет документа про термины». Это отсутствие опоры для всей онтологии.

Это проявляется очень конкретно:

— появляются дублирующие сущности с похожими, но не совпадающими комментариями,

— связи между объектами становятся случайными и нерелевантными,

— команды смотрят на одну и ту же диаграмму и видят в ней разное,

— любые изменения начинают с обсуждения не сути, а терминов,

— AI большую часть времени занят тем, что «догадывается», а не понимает.

В какой-то момент я честно сказал себе: "если я не управляю языком модели, то модель по определению неуправляема."

И с этого момента словарь перестал быть частью «документации» и занял своё настоящие место — фундамент живой онтологии.

Как я пришёл к идее OntoLex

У меня давно была одна устойчивая боль: каждый раз, когда мне попадался важный документ — презентация, исследование, концепция — я пытался вытащить из него главное. Не краткое саммари, не пересказ, а структуру знания, ту самую «внутреннюю карту смысла», по которой этот документ вообще создан.

Мне всегда не хватало инструмента, который бы не просто сокращал текст, а показывал:

какие идеи в нём живут, как они связаны и откуда взялись.

По сути, мне нужен был ключ — проводник в ту область знания, из которой этот документ вырос. И довольно быстро стало очевидно, что самым честным, формальным и переносимым таким ключом является словарь, но не в виде списка слов, а в виде сети понятий.

Проблема была только в одном:

делать такой словарь вручную — тяжёлое ремесло.

Это бесконечное выписывание терминов, борьба с дубликатами, разбор формулировок, попытки держать в голове связь между страницами. Долго, утомительно и почти всегда недоделано.

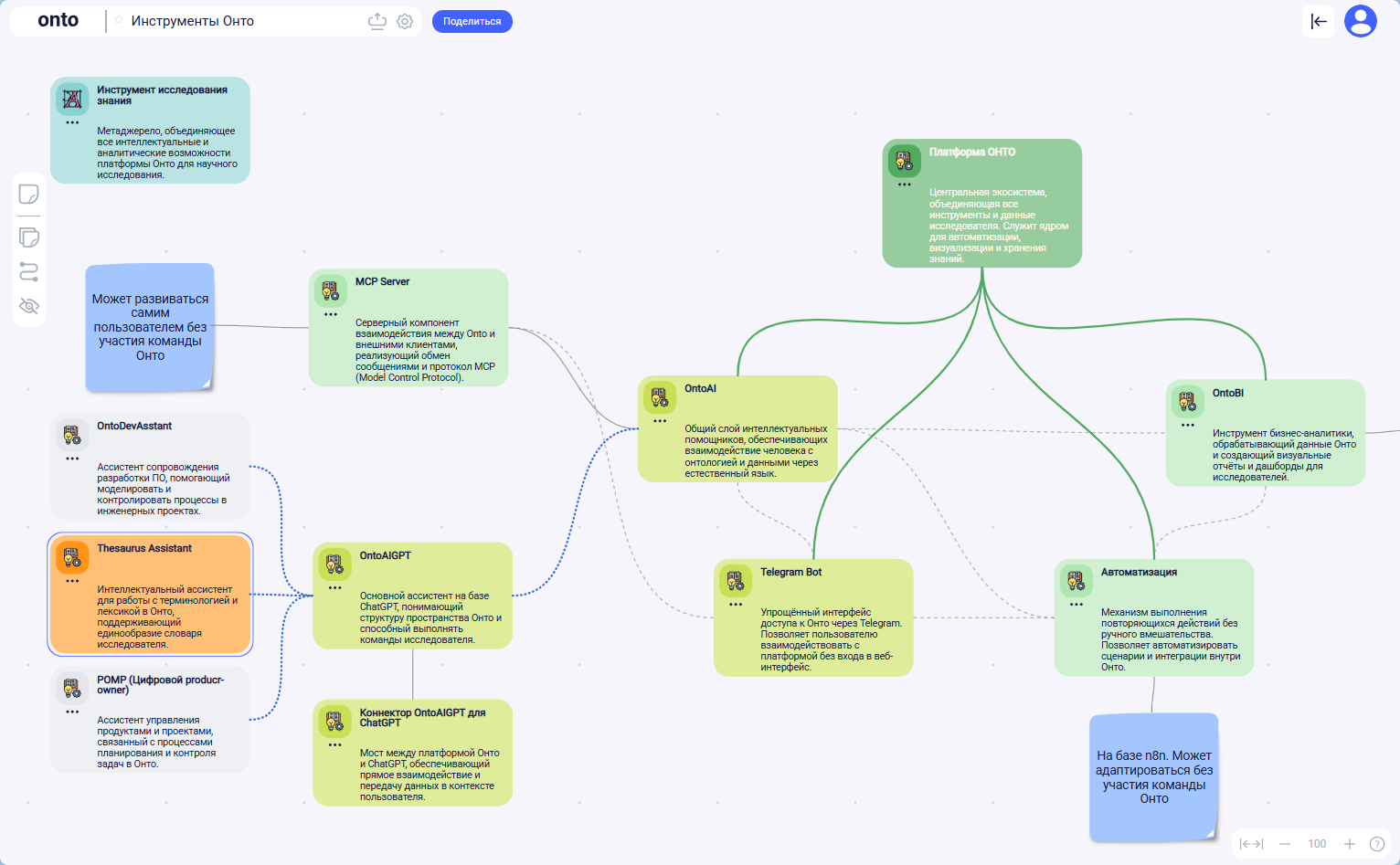

А потом у меня появился OntoAI — механизм, который позволил быстро собирать ассистентов под свои задачи.

И вдруг стало очевидно: если система уже умеет работать со связями, понятиями и классами, то почему бы не научить её помогать мне с документами?

Так появился OntoLex.

Не как «продукт», не как «фича», а как контекстный инструмент для решения моей собственной боли:

- взять документ,

- извлечь смысл,

- собрать словарь,

- перевести всё в онтологию,

- и сделать это не героическим усилием, а регулярной процедурой.

Шаг за шагом стало понятно, что создание ассистента «для извлечения знаний в виде связанного словаря» — это самое простое и естественное решение.

OntoLex просто занял своё место в моём ритуале:

я открываю документ, запускаю его — и дальше уже не думаю о механике, а работаю только со смыслом.

Почему я использую OntoLex: ассистент, который превращает рутину в смысл

Я смирился с тем, что разбор документа — это не озарение и не творческий подвиг, а довольно скучное ремесло. Открываешь PDF или страницу в Confluence, читаешь, выписываешь термины, ищешь дубли, решаешь, что есть сущность, что — атрибут, что — процесс, что — ценность. Если делать это вручную, каждый документ — маленький персональный ад исследователя. Полезный, но совершенно не масштабируемый.

Чем OntoLex принципиально отличается от привычных «умных помощников» из мира текста?

- Во-первых, он не работает «над документом», он работает внутри онтологии. Для него слово — это не просто токен, а потенциальный объект, который может занять своё место в графе.

- Во-вторых, он узнаёт термины, которые уже есть в словаре, и аккуратно встраивает их в контекст, а не плодит дубли под разными формулировками.

- В-третьих, он честно говорит: «здесь, кажется, новое понятие» — и предлагает создать сущность, а не просто выделить жирным.

- В-четвёртых, он сразу спрашивает: это ценность, концепция, ключевой термин, второстепенный термин? То есть подталкивает к онтологическому решению, а не к ещё одному списку слов.

- И, наконец, он умеет работать страница за страницей, превращая документ в карту смыслов, а не в очередной «подсвеченный текст».

Но главное — OntoLex делает процесс повторяемым.

Не один храбрый подвиг в стиле «мы однажды провели онтологический анализ этой презентации».

А понятная, спокойная, воспроизводимая процедура:

- Задали пространство.

- Подняли базовый словарь.

- Описали источник и его разделы.

- Прошли документ постранично.

- Получили живую онтологию, с которой можно работать дальше.

После этого словарь перестаёт быть артефактом, лежащим «где-то рядом».

Он становится центральным рабочим инструментом:

— и для меня как моделирующего,

— и для команды, которая смотрит на одну и ту же систему,

— и для AI, который наконец-то начинает опираться на чётко очерченный язык, а не на догадки.

Поэтому, когда ко мне попадает новый документ — презентация, концепция, регламент, исследование — у меня рефлекс один и тот же: открыть OntoLex и превратить эту штуку не в ещё один файл, а в кусок живой онтологии.